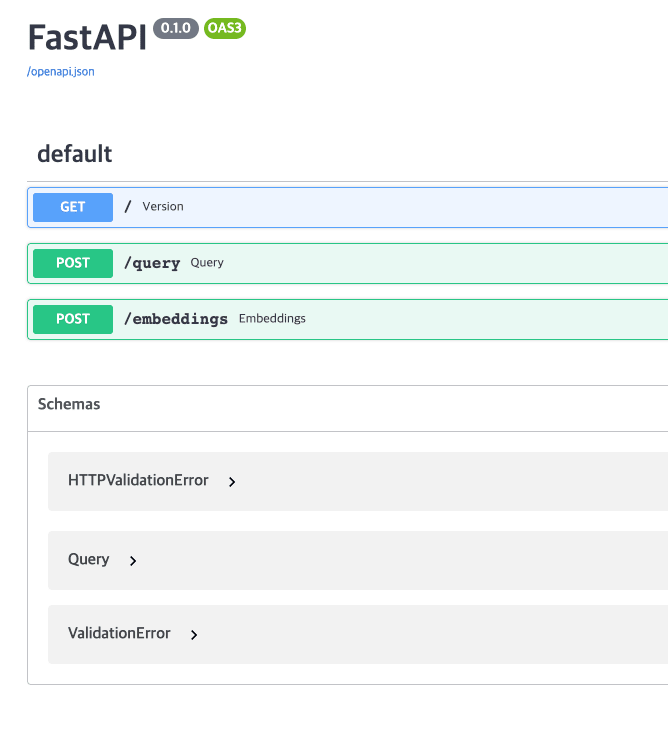

ChatGPT 가 유행하면서 Nvidia 의 GPU가 핵심 하드웨어로 간주되고 있습니다. Nvidia 는 전세계 최강자이며 이를 따라가는 다양한 Startup 들이 존재합니다. 하지만 AWS 역시 내부적으로 NVidia의 GPU가 아닌 NPU(Neural Processing Unit)를 제공하고 있습니다. GPU를 통해서 학습(Training)과 추론(Inference)을 하는데 이 두 영역은 고객군이 불리되는 경우가 많으니 학습 전용 HW와 추론 전용 HW를 분리하여 제공하는 것이 비용 및 성능 효율적이라고 생각합니다. 예를 들어, 우리나라의 혁신적인 스타트업인 리벨리온(Rebellions)는 추론 영역의 HW를 타겟팅한 회사 입니다. 오늘은 AWS 추론엔진인 Inferentia2를 간단하게 공부해 보..